运维

2月24日 · 2018年

Haproxy进阶管理:命令行控制后端节点上下线

1695 11 11

9月2日 · 2017年

Haproxy安装部署文档及多配置文件管理方案

3690 21 8

6月29日 · 2016年

企业互联网+转型实战:如何进行PB级别数据的架构变迁

3059 22 0

3月30日 · 2016年

GOPS2016全球运维大会•深圳站自动化、云计算、老王专场精彩PPT分享

1258 44 38

11月22日 · 2015年

php5编译安装常见错误和解决办法集锦

1418 6 10

4月8日 · 2015年

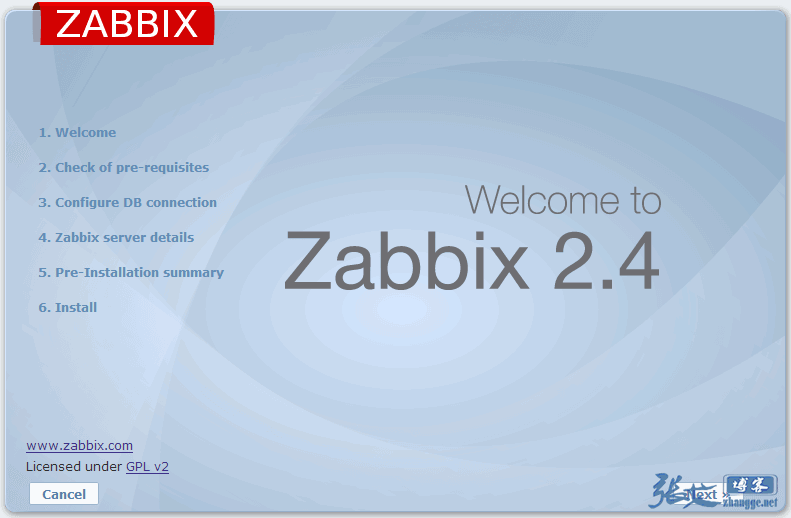

zabbix agentd客户端插件Shell一键自动安装脚本

1003 9 5

4月12日 · 2014年

和同事一起弄了个新网站:爱运维

4057 11 47

12月19日 · 2013年

分享一个Linux无法创建文件夹,但是目录权限却显示正常的问题和解决

7511 5 0

12月18日 · 2013年

详解Linux运维工程师必备技能

3383 13 1